こんにちは。

とあるメーカーで貿易の仕事に関わって20年超の神高(かんだか)です。

ChatGPT(チャットジーピーティー)という対話型の AI(人工知能)を貿易実務などの仕事で使いたい、と考えていますか?

実は、ぼくも「文字を扱う作業が多いから、対話型AIは貿易実務とも相性が良いんじゃないか?」と考えて、さっそく、プライベートで試しているところです。

1か月課金して、GPT-4(最新版)も触ってみました。

いやあ、想像した以上に賢いし、レスポンスも早い。

人間の仕事が奪われる、という脅威論が出てくるのも理解できます。

とはいえ、逆に「注意しなければならないこと」「危険な使い方」もあるんですよね。

職場の後輩から質問されたときのためにも、ここに3つの注意点を書き記しておきます。

金額や具体的な社名など、重要な情報を書き込んではいけない|注意点①

金額や具体的な社名など、重要な情報を書き込んではいけない。

これが一つ目の注意点です。

貿易実務、あるいは海外とビジネス、商売をしていると、英文を翻訳する場面がよくあります。

- 売買契約書

- 製品カタログやウェブの商品説明

- 納期や価格を交渉する電子メール

書いていてもキリがないほど、多くの文章を外国語で扱っています。

そして、これらの文面を翻訳する機能をすでに人工知能は持っています。

ただ、インプットする、ということは、遠く海外(日本かも知れませんが)のサーバーにデータが永遠に残る、ということ。

たとえば、契約書を翻訳ソフトにかけると、金額や細かな条件まで、すべて人工知能の運営会社に取り込まれてしまいます。

ですから、社会人として人工知能を使うときは「情報漏洩リスクはないか」、という視点は、いくら便利でも忘れてはいけません。

その意味では、

- 売買契約書 → 無償の翻訳サービスは NG

- 製品カタログやウェブの商品説明 → 世の中に出ている公開情報ならOK

- 納期や価格を交渉する電子メール → 社名や商品名を仮の名前にして翻訳

といった判断になるでしょう。

実際、体験したんですよ。

DeepL や Google 翻訳(翻訳サイト)で、アウトプットになぜか個人名や会社名、商品名が出力される例を。

自分も気をつけなきゃな、と思い直しました。

ChatGPT の翻訳能力もなかなかのものです。

たとえば、貨物を輸出するときのメールを ChatGPT(GPT-4)にかけると、これくらいは数秒で返してくれます。

- 日本語「神戸からの出荷を予定していた商品ABCの船積みが台風接近により1週間遅延します。具体的にはETDが2023年8月1日から8日になります。船名の変更はありません。ご了承ください。」

- 英文翻訳「The shipment of product ABC, which was scheduled to be shipped from Kobe, will be delayed by one week due to the approaching typhoon. Specifically, the ETD will be postponed from August 1st, 2023 to August 8th, 2023. There will be no changes to the name of the ship. Please understand.」

もう少し表現を変えたほうが伝わりやすいかな、という箇所はあるものの、ある程度、パターン化された日々の英文メールなら十分なアウトプットでしょう。

例文の中では ABC とした箇所を、具体的な商品名、あるいは契約番号などに変えれば、実用レベルです。

ChatGPTが自信満々に答えてきても、真実とは限らない|ハルシネーション 注意点②

ChatGPTが自信満々に答えてきても、真実とは限らない。

これが二つ目の注意点です。

この現象は、ハルシネーション (英語: hallucination、日本語だと「幻覚」) と呼ばれるんですけどね。

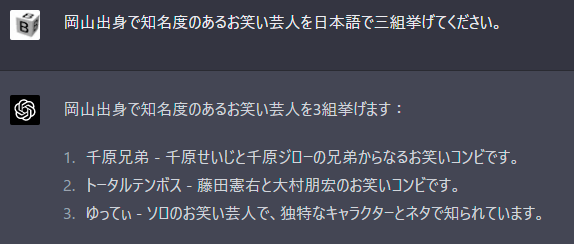

専門的な内容だとわかりにくいので、かなり軽い質問を ChatGPT に投げかけて事例を見ましょう。

2023年3月25日時点での GPT-4 の回答は以上になります。

質問:岡山出身で知名度のあるお笑い芸人を三組挙げてください。

岡山出身で知名度のあるお笑い芸人を3組挙げます:

- 千原兄弟 – 千原せいじと千原ジローの兄弟からなるお笑いコンビです。

- トータルテンボス – 藤田憲右と大村朋宏のお笑いコンビです。

- ゆってぃ – ソロのお笑い芸人で、独特なキャラクターとネタで知られています。

どうです、3組とも全然違うでしょう。

まず、千原ジローって誰(笑)? (正しくは、千原ジュニアさん)

テレビでお笑い番組をご覧になる方ならば、岡山県出身のコメディアンとしては、真っ先に「千鳥」「ウエストランド」などが挙がるところだと思います。

いや、Open AI を馬鹿にしたいわけではないんですよ。

逆に、AI を軽く見たり、まだまだと考えたりする付き合い方は、実情に合ってない。

日々、進歩している感覚すらあります。

それでも、分野によっては、これくらいの回答をすることもある、というサンプルです。

同じようなことが、たとえば法律の分野で起きたら、慣れない我々は AI の回答を信じてしまいますよね。

ChatGPT の表現は、常に「自信満々」なんですよ。

「当然、知ってますよ」と。

「ゆってぃ – ソロのお笑い芸人で、独特なキャラクターとネタで知られています。」

と、ネタのスタイルについてまで、補足説明を入れてくるほど。

しかし、Wikipedia に書いてある「東京都杉並区出身」という情報は、まだ拾わない。

.jpeg)

参照しないのは、あえて、の可能性もありますよ、それは。

ということで、AI も使う側の知識、「あれ、おかしいな」と気づく能力は問われます。

著作権のことまでは、おそらく ChatGPT は考えてくれない|注意点③

著作権のことまでは、おそらく ChatGPT は考えてくれない。

これが三つ目の注意点です。

将来的には、勝手にパクリやコピーの判定をしてくれる AI も出てくると思います。

しかし、今はまだ、その判定ができるレベルにありません。

逆に、先に挙げた「岡山出身芸人」の事例のように、Wikipedia すら勝手に参照することはないようです。今のところは。

しかし、逆に AI に教え込む側が著作権侵害をしている可能性があります。

たとえば、著作権が切れていない書籍を人工知能に教え込み、結果、出力される内容が原典と全く同じ内容だったとすれば、これは著作権侵害に当たります。

ChatGPT は「村上春樹風の文章を200文字程度で書いて」なんて、無茶な要求にもこたえてくれます。

例:「空の色は、夕暮れ時のような不思議なオレンジがかったグレーで、時折かすかな雨が降り注いでいた。街角の喫茶店で、僕は一人コーヒーをすする。(さらに出力できますが、伏せます)」

ほぉ、悪くない。

何度か生成しましたが、ネットで検索した限り、元ネタはなく、都度、生成しているようです。

とはいえ、インターネット上にデータがない、電子書籍化もされていない作品の一部とも限らない。

となると、「電子書籍を人工知能で出版しました!」といっても、検証は簡単ではありません。

たとえば、勤め先が新しい製品を開発して、カタログを作成するとします。

簡単な情報を入れれば、おそらく人工知能は、それらしいキャッチコピーや商品紹介文を生成してくれるでしょう。

とはいえ、その文章が他社のカタログをゴッソリ流用していたら、さすがに問題です。

自動的に、それらしい表現を選んでくれていたとしても。

その意味で、仕事で使う場合には、まだ著作権チェックは自分で検索したり、同業他社の発表を調べたり、といった「判断」は人間の仕事として残りそうです。

まとめ:ChatGPTを貿易実務などの仕事で使うときの注意点とは?|日本語翻訳も非常に優秀だけど……

人工知能の発展、ちょっと怖いくらいですね。

とはいえ、途中の事例で紹介したような種類の「判断」も、人間の仕事として最後まで残りそうな気がします。

ここまでの内容をまとめておきます。

最新の人工知能(ディープラーニング)は、圧倒的なデータ量と統計的な手法を用いて人間らしいリアクションをするように発展してきたそうです。

将棋のようなゲームにせよ、会計ソフトにせよ、得意分野からどんどん AI は取り入れられることでしょう。

その意味では、扱う量が増えれば増えるほどより高度な回答ができる。

しかしながら、体系化されていない知識や経験については、必ずしも適切に反応できるとは限りません。

なぜなら、そもそも元になる生のデータが少ないからです。

貿易実務の分野も、ワンパターンのようで、切り口によって様々で多様ですよね。

もちろん、パターン化された仕事、ルーチンワークはあります。

しかし、扱う商品がさまざまで、インコタームズ(INCOTERMS)にしても契約条件にしても、パターン化されてるとはいえ、商品、相手によってバラバラです。

さらに、国や人種によって、担当者(客先やフォワーダーなど)の性格や考え方も違う。

となると、「パターン化された仕事」と「それ以外の判断を必要とする仕事」という振り分けをしていかなければならない時代がしばらく続くのではないでしょうか。

やっぱり、「判断」は残ります。

逆に言えば、定型化された仕事、分野はだんだん人工知能に取って代わられるのでしょう。

50歳、60歳になっても、新しい分野にチャレンジする気力、残っているかなあ(笑)

みなさん、がんばって生き延びましょう。

を使いたい|マイクロソフトはいつ日本に導入するのか-120x68.jpg)